Vícevrstvý perceptron

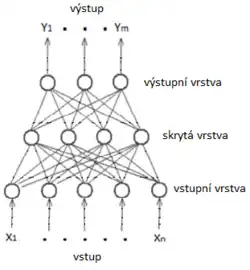

Vícevrstvý perceptron (Multi-Layer Perceptron, MLP) je dopředná umělá neuronová síť. MLP se skládá nejméně ze tří vrstev perceptronů: vstupní vrstvy, skryté vrstvy a výstupní vrstvy. MLP využívá k trénování techniku učení s učitelem, což je řešení optimalizačního problému minimalizace chyby funkce sítě vzhledem k tréninkovým datům v závislosti na parametrech sítě. Zpravidla se k tomuto účelu užívá algoritmus zpětného šíření chyby, je možné užít i heuristické optimalizační techniky, jako např. genetický algoritmus či simulované žíhání. Více vrstev a spojitá přenosová funkce (sigmoida) odlišují MLP od Perceptronu. Dokáže rozlišit data, která nejsou lineárně oddělitelná. Obecně pracuje jako aproximátor libovolné vektorové funkce (Kolmogorův teorém)[1], tj. během učení provádí nelineární regresi. Používá se k řešení širokého spektra úloh, jako je rozpoznávání, klasifikace, diagnostika či predikce, lze jej využít i ke kompresi a kryptování dat (viz autoenkodér).

Reference

- ↑ HORNIK, K. Multilayer feedforward networks are universal approximators, Neural Networks 2 (5). [s.l.]: Elsevier, 1989. 8 s. (anglicky)

Literatura

- KŘIVAN, Miloš. Umělé neuronové sítě. [s.l.]: Nakladatelství Oeconomica, Vysoká škola ekonomická v Praze 77 s. Dostupné online. ISBN 978-80-245-2420-7.